Informations personelles

Je vie actuellement avec ma fiancée à Martigny (Valais, Suisse) et je travaille comme assistant de recherche à

l'Institut de Recherche de l'Idiap. J'ai grandi dans le Chablais Valaisans, prêt

de mon lieu de vie actuel, et j'ai étudié à l'EPFL où j'ai obtenu un Bachelor (BSc) en

microtechnique (2014) puis un Master (MSc) en robotique et systèmes autonomes (2016).

Pendant mon temps libre, je pratique le Judo au Judo Club Saint-Maurice, dont

je suis vice-président et directeur technique. J'étudie cet art martial depuis 23 ans et j'ai obtenu le 2e Dan (ceinture

noire) en 2018. Je donne des cours aux enfants de 8 à 12 ans et je les coachs en compétition.

Je suis aussi un fan de jeux vidéos et de jeu de rôle sur table, auxquels je joue régulièrement avec mes amis.

Recherche actuelle

Je suis actuellement doctorant à l'EPFL (EDEE) et je travaille à l'Idiap comme assistant de recherche dans le groupe Perception and Activity Understanding sous la supervision de Jean-Marc Odobez.

Estimation du centre d'attention visuel

De plus en plus de systèmes intelligents, comme des robots, doivent interagir avec des êtres humains. Afin de participer à une conversation et se comporter naturellement, ces systèmes ont besoin de comprendre la dynamique de la conversation. La perception de l'attention des participants est un facteur clé de cette dynamique et elle permet entre autres d'estimer la personne à qui un participant s'adresse, les prises de paroles, l'engagement des participants dans la conversation, etc. Cependant, l'attention est un comportement complexe et un procédé cognitif qui est difficile à observer pour un agent artificiel.

Afin de relever ce défi, le centre d'attention visuelle (CAV), c'est-à-dire où une personne est en train de regarder, peut-être utilisé comme remplacement pour l'attention. Ainsi, estimer le CAV des participants à une discussion et plus généralement modéliser la dynamique d'une conversation permet aux systèmes intelligents comme les robots de mieux comprendre les humains et de réagir correctement lorsqu'ils interagissent avec nous. Implémenter ces modèles sur de vrais robots ajoute des contraintes à la tâche déjà complexe d'estimer l'attention: un robot dispose d'un point de vue unique de ce qui l'entoure, il évolue en général dans des environnements hautement dynamiques et il doit traiter toutes les informations qu'il reçoit en temps-réel.

Estimation du biais du regard

Le regard est une composante non verbale importante incluse dans de nombreuses facettes des interactions sociales comme la communication, l'attention ou l'attitude. Néanmoins, l'extraction de la direction du regard par des capteurs visuels et distants (comme des caméras) souffre en général d'erreurs importantes causées par la faible résolution des images des yeux, les erreurs de localisation des yeux ou la variation de la forme des yeux entre différentes personnes, entre autres. Pour compenser ces erreurs d'estimation, nous avons proposé une méthode qui exploite le contexte de l'interaction en se basant principalement sur les tours de parole.

Reconaissance des mouvements oculaires

Au-delà de l'estimation instantanée de la direction du regard, les analyses du regard peuvent souvent bénéficier de la reconnaissance des mouvements des yeux comme la fixation, la saccade (changement de fixation), le clignement de l'oeil, ... Cette reconnaissance ne permet pas seulement de débruiter le signal de la direction du regard - ce qui améliore l'estimation de l'attention - mais aussi d'obtenir une meilleure caractérisation de l'activité oculaire, ce qui est utile pour l'analyse des comportements. Nous sommes intéressés dans le cas où des caméras RGB-D (couleur et profondeur), qui ont une faible fréquence d'échantillonnage et qui fournissent des images oculaires de basse résolution, sont utilisées pour filmer des gens lors d'interactions sociales naturelles. Pour ce faire, nous avons étudié des méthodes de deep learning qui traitent directement des séquences d'images d'oeils pour reconnaître ces mouvements oculaires.

Resources

VFOA module - un package python pour l'estimation basique de l'attention visuelle d'une personne (modèles géométriques et statistiques).

Dataset ManiGaze - un dataset collecté pour évaluer l'estimation du regard avec des capteurs distants (caméra RGB-D).

Activitées passées

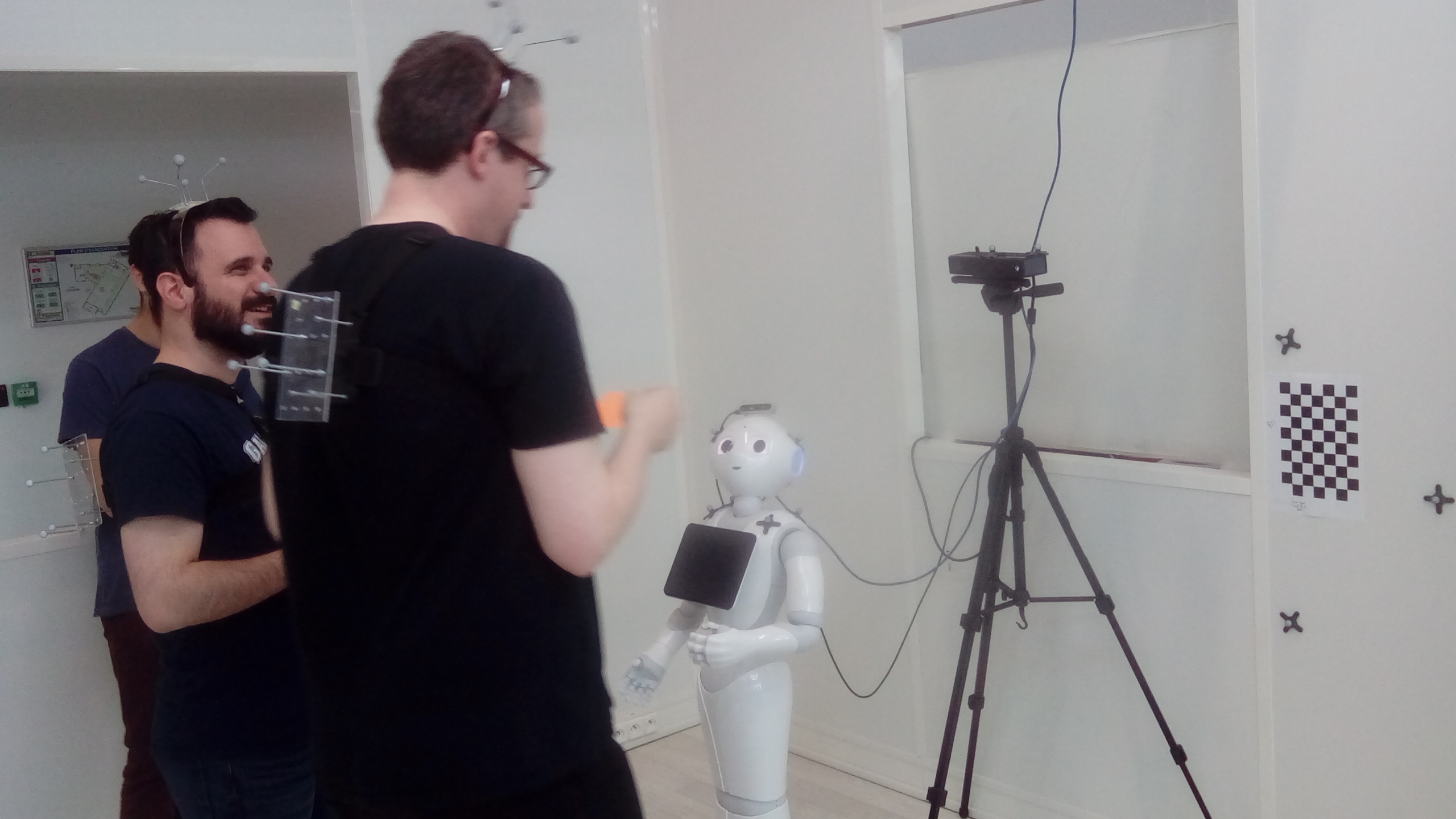

2018-2020 Dans le cadre du projet MuMMER, j'ai travaillé

sur la modélisation et l'inférence de l'attention visuelle dans les interactions homme-homme et homme-robot.

Mon objectif était d'estimer l'attention des personnes participant à une conversation, qui peut inclure des robots,

en exploitant l'information enregistrée par des capteurs visuels (couleur et profondeur) et audios.

En reconnaissant l'attention des personnes, les systèmes intelligents, tels que les robots ou les assistants pesonnels intelligents,

seront en mesure de mieux nous comprendre et de réagir de façon plus appropriée durant les interactions sociales.

15.10.2020 - Interview de Canal 9

17.09.2019 - Article présentant le système développé pendant le projet (arxiv paper)

29.04.2019 - Démonstration du module de perception développé par l'équipe de l'Idiap (vidéo youtube)

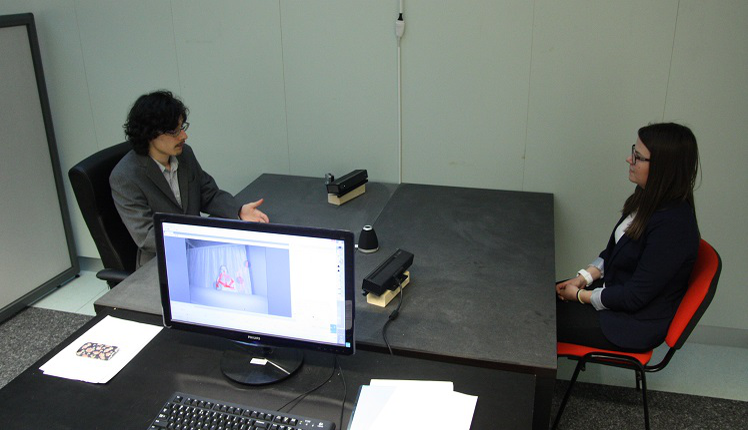

2017 Pendant mon doctorat, j'ai participé au projet UBImpressed, financé par le programme interdisciplinaire Sinergia du Fond National Suisse de la Recherche Scientifique (FNSNF). Ce projet portait sur l'étude de la relation entre les comportements non verbaux et la formation d'une bonne impression en combinant la recherche sur la communication non verbale et les technologies de perception et d'apprentissage automatique (machine learning). Dans ce contexte, j'ai travaillé sur l'amélioration d'un traqueur oculaire pour extraire automatiquement la direction du regard des candidats à un entretien d'embauche ce qui a permi à nos partenaires d'analyser l'impact du regard sur la formation de la première impression.

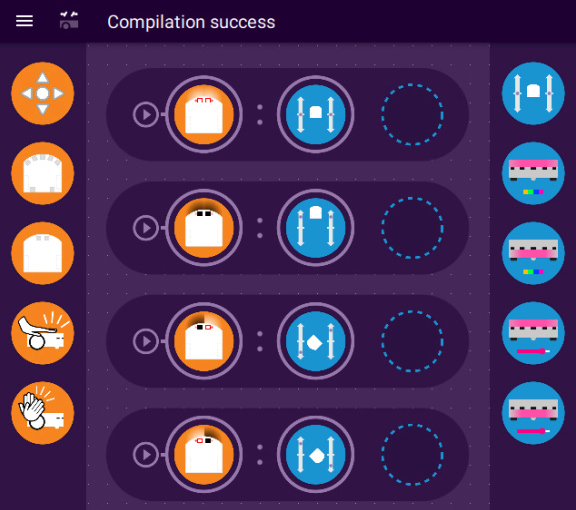

2016 J'ai effectué mon projet de Master au MOBOTS (EPFL) sous la supervision de Francesco Mondada. J'ai travaillé dans le domaine de l'analyse de l'apprentissage avec des robots mobiles et participé au développement de méthodes qui utilisent des logs enregistrés pendant des leçons de programmations de robot pour fournir des informations utiles aux enseignants et aux élèves dans le but d'augmenter l'efficacité de ces cours. J'ai ensuite été engagé 6 mois de plus pendant lesquels nous avons développé un outil qui fournit des conseils immédiats à des élèves qui apprennent à programmer un robot basé sur les résultats constatés lors de mon projet de Master. Ce travail fut publié en 2017.

2015 J'ai travaillé 7 mois chez senseFly (à Cheseaux-sur-Lausanne) sur le contrôle moteur de leur quadrotor et le dévelopement d'une interface entre leur drone fix-wing et une nouvelle caméra.

Media

08.09.2020 (reporté à cause du COVID-19) - Conférence intitulée "Penser sans cerveau: la logique robotique"

organisé par Science Valais à Sion, dans le cadre du festival international Pint of Science

29.03.2019 - "Portrait de chercheur" (vidéo youtube en français) réalisé par Science Valais

29.08.2018 - Innovation Days 2018 à l'Idiap (video du journal "20 Minutes") dans laquelle je présente une démo d'un trackeur de visage et de regard (position et orientation de la tête, direction du regard, cible de l'attention).

Publications

Visual Focus of Attention Estimation in 3D Scene with an Arbitrary Number of Targets

R. Siegfried and J.-M. Odobez

IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPR-GAZE2021), Virtual, June 2021

ManiGaze: a Dataset for Evaluating Remote Gaze Estimator in Object Manipulation Situations

R. Siegfried, B. Aminian, and J.-M. Odobez

ACM Symposium on Eye Tracking Research and Applications (ETRA), Stuttgart, June 2020

MuMMER: Socially Intelligent Human-Robot Interaction in Public Spaces

M. E. Foster, O. Lemon, J.-M. Odobez, R. Alami, A. Mazel, M. Niemela, et al.

AAAI Fall Symposium on Artificial Intelligence for Human-Robot Interaction (AI-HRI), Arlington, November 2019

A Deep Learning Approach for Robust Head Pose Independent Eye Movements Recognition from Videos

R. Siegfried, Y. Yu, and J.-M. Odobez

ACM Symposium on Eye Tracking Research and Applications (ETRA), Denver, June 2019

Facing Employers and Customers: What Do Gaze and Expressions Tell About Soft Skills?

S. Muralidhar, R. Siegfried, J.-M. Odobez, and D. Gatica-Perez

International Conference on Mobile and Ubiquitous Multimedia (MUM), Cairo, November 2018

Towards the Use of Social Interaction Conventions As Prior for Gaze Model Adaptation

R. Siegfried, Y. Yu, and J.-M. Odobez

ACM International Conference on Multimodal Interaction (ICMI), Glasgow, November 2017

Supervised Gaze Bias Correction for Gaze Coding in Interactions

R. Siegfried and J.-M. Odobez

Communication by Gaze Interaction (COGAIN) Symposium, Wuppertal, August 2017

Improved mobile robot programming performance through real-time program assessment

R. Siegfried, S. Klinger, M. Gross, R. W. Sumner, F. Mondada, and S. Magnenat

ACM Conference on Innovation and Technology in Computer Science Education (ITiCSE), Bologna, July 2017